大數據工程師手冊 全面系統的掌握必備知識與工具

在當今數據驅動的時代,大數據工程師已成為技術領域的關鍵角色。他們負責設計、構建和維護能夠處理海量數據的基礎設施與系統,是連接數據源與商業價值的橋梁。本手冊旨在為有志于成為大數據工程師或希望系統提升技能的開發者提供一份全面的指南,涵蓋從基礎概念到核心工具,再到實戰開發的完整知識體系。

一、 大數據基礎與核心概念

成為一名合格的大數據工程師,首先需要建立堅實的理論基礎。這包括理解大數據的核心特征(4V或5V:Volume體量、Velocity速度、Variety多樣性、Veracity準確性、Value價值),以及相關的處理范式。

- 分布式系統原理:大數據處理的基石。需要理解分布式計算、存儲、協調和容錯的基本原理,如CAP定理、一致性模型、共識算法(如Paxos、Raft)等。

- 數據處理范式:掌握批處理與流處理的區別與聯系。批處理適用于對海量歷史數據進行離線分析,而流處理則專注于實時或近實時數據的連續處理。理解Lambda架構和Kappa架構等經典設計模式。

二、 核心技能棧與必備工具

大數據工程師的技能棧可以概括為“一基、三核、多工具”。

- 編程基礎(一基):

- Java/Scala/Python:Java是Hadoop生態的基石;Scala是Spark的首選語言,函數式編程特性在處理數據時優勢明顯;Python則以其簡潔和豐富的數據科學庫(如Pandas, NumPy)在數據分析、機器學習和快速原型開發中占據重要地位。扎實掌握至少一門是入門的關鍵。

- 三大核心技術棧(三核):

- 存儲層:理解分布式文件系統(如HDFS)和NoSQL數據庫(如HBase, Cassandra)的原理與應用場景。數據湖(如基于HDFS或云原生對象存儲)和數據倉庫(如Hive, ClickHouse, Snowflake)的概念與選型也至關重要。

- 計算層:

- 批處理:Apache Spark是當前事實上的標準,需精通其RDD/DataFrame/Dataset API、執行計劃優化、內存管理等。經典的MapReduce(Hadoop)原理仍需了解。

- 流處理:Apache Flink以其先進的流計算理念(如事件時間、狀態管理)成為主流;Apache Kafka Streams和Spark Streaming也是重要選項。理解流處理的核心概念,如時間窗口、水位線、Exactly-Once語義等。

- 資源管理與調度:YARN是Hadoop生態的傳統資源管理器;Kubernetes正成為云原生時代統一編排和部署大數據應用的新標準,需要掌握其基本概念與運維。

- 關鍵輔助工具(多工具):

- 消息隊列/日志收集:Apache Kafka,作為高吞吐的分布式消息系統,是大數據流水線的“中樞神經”,用于解耦數據生產與消費。

- 工作流調度:Apache Airflow或DolphinScheduler,用于編排復雜的數據處理任務依賴關系,實現自動化調度。

- 數據攝取與同步:Sqoop(關系數據庫與HDFS之間)、Flume/Canal(日志/增量數據采集)、DataX、Debezium等。

- 集群管理與監控:Ambari, Cloudera Manager(商業版)或自行搭建的Prometheus + Grafana監控體系。

三、 從開發到實戰:基礎軟件開發實踐

大數據工程師不僅是工具的運用者,更是系統的構建者。基礎軟件開發能力是區分高級工程師與普通用戶的關鍵。

- 設計與編碼:

- 模塊化與可復用性:將數據處理邏輯封裝成獨立的、可測試的模塊或函數。

- 配置化驅動:避免硬編碼,將環境變量、連接參數、業務規則等抽取為配置文件,提高系統的靈活性和可維護性。

- 代碼規范與質量:遵循團隊的編程規范,善用單元測試(如JUnit, pytest)和集成測試保證代碼質量。理解并使用設計模式解決常見架構問題。

- 性能調優:

- 數據傾斜處理:這是分布式計算中最常見的問題之一,需要掌握使用加鹽、雙重聚合等策略來應對。

- 資源優化:根據任務特性合理設置Executor數量、內存、CPU核心數等參數。理解并優化Spark的Shuffle過程、存儲級別選擇。

- SQL與執行計劃:對于Hive/Spark SQL,能夠閱讀和分析執行計劃,通過優化SQL寫法、建立合適的分區與分桶、使用合適的Join策略來提升性能。

- 數據質量與治理:

- 在數據流水線的關鍵節點設計數據質量檢查規則,如非空校驗、唯一性校驗、數值范圍校驗等。

- 實現數據血緣追蹤,記錄數據的來源、轉換過程與去向,便于問題排查和影響分析。

- 關注數據安全與隱私保護,實施數據脫敏、訪問控制等策略。

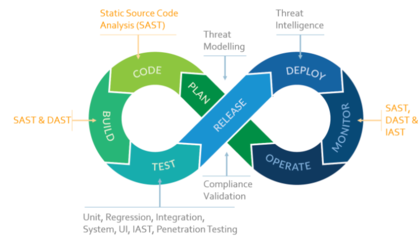

- 部署與運維:

- 容器化:使用Docker將應用及其依賴打包,實現環境一致性。

- CI/CD:建立持續集成/持續部署流水線(如使用Jenkins, GitLab CI),自動化代碼檢查、測試、構建和部署過程。

- 可觀察性:在代碼中埋點,記錄關鍵指標和日志,與監控系統聯動,實現問題的快速定位與預警。

四、 學習路徑與持續成長

大數據技術生態日新月異。建議的學習路徑是:先深度,后廣度。首先選擇一個核心領域(如Spark或Flink)深入鉆研,理解其內部原理和最佳實踐,構建起處理某類問題(批或流)的完整知識閉環。然后橫向擴展,了解生態中的其他組件,并關注云原生(如Kubernetes上的Spark/Flink)、湖倉一體、實時數倉等前沿趨勢。

積極參與開源社區,閱讀優秀項目的源代碼,在實踐中不斷解決真實場景下的復雜問題,是成長為一名卓越大數據工程師的必經之路。記住,工具和技術會演變,但處理海量數據的核心思想、系統設計能力和扎實的工程實踐功底,才是你職業生涯中最寶貴的財富。

如若轉載,請注明出處:http://www.ndutipx.cn/product/68.html

更新時間:2026-01-07 23:42:17